2024年,天津大学智能与计算学部VisDrone团队在全体成员的共同努力下,勇毅前行,开拓创新,取得了令人瞩目的成果。2025年,随着新的一年到来,万象更新,VisDrone团队将继续秉承“奋发有为,勇攀高峰”的精神,紧跟人工智能和智能无人系统领域的前沿发展,在更广阔的技术蓝海中披荆斩棘,迎接更加辉煌的未来!

2024年,天津大学VisDrone团队在低代价学习、协同学习以及进化学习领域共发表和录用论文18篇。包括:

在论文合作方面,我组成员共参与发表了1篇CCF-A类期刊论文和1篇SCI一区论文。

下文将对代表性论文进行简要介绍。

NeurIPS, 全称Conference on Neural Information Processing Systems, 该会议是国际人工智能和机器学习领域顶级会议之一,本届会议录用率为25.8%。

论文题目:Conditional Controllable Image Fusion

作者:曹兵,徐兴歆(博士研究生),朱鹏飞,王旗龙,胡清华

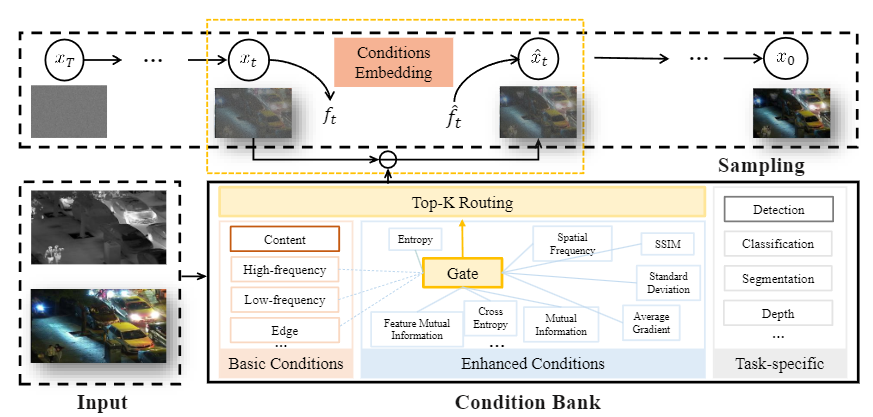

论文概述:图像融合旨在整合通过各种传感器或光学设备获取的多个图像中的互补信息,以合成包含更丰富信息的新图像。现有方法通常采用针对特定场景量身定制的不同约束设计,形成固定的融合范式。然而,这种数据驱动的融合方法不适用于所有场景,尤其是在快速变化的环境中。为了解决这个问题,我们首先提出了一个条件可控融合 (CCF) 框架,无需特定训练就可以用于一般的图像融合任务。由于不同样本的动态差异,CCF可以对每个个体采用特定的融合约束。鉴于去噪扩散模型的巨大重建能力,我们将特定约束注入预训练的 DDPM 作为自适应融合条件。动态选择适当的条件以确保融合过程在反向扩散阶段仍然响应特定要求。因此,CCF 能够逐步有条件地校准融合图像。大量实验验证了我们在各种场景中融合任务的有效性,而无需额外的训练即可与现有方法相媲美。

论文链接:https://arxiv.org/pdf/2411.01573

论文代码:https://github.com/jehovahxu/CCF

论文题目:What Matters in Graph Class Incremental Learning? An Information Preservation Perspective

作者:李佳璐(博士研究生),王煜,朱鹏飞,林婉瑜,胡清华

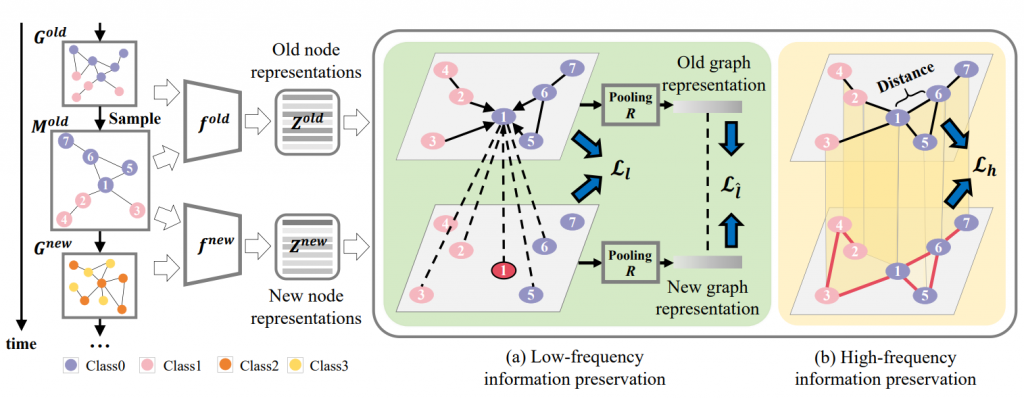

论文概述:图类增量学习要求模型在记忆旧类的同时对新类的新节点进行分类。现有的方法旨在保留旧模型或图数据的有效信息以减轻遗忘,但对信息保存的重要性没有明确的理论认识。在本文中,我们根据两个设计的偏差指标评估目前的做法得出现有方法存在高语义和结构偏差的结论。我们对图类增量学习中的信息保存进行了深入的研究,发现维护图信息在理论上可以保留旧模型的信息,以校准节点语义和图结构的变化。我们将图信息在空间域分解为低频局部-全局部分和高频部分。在此基础上,我们提出了一个通用的框架——图空间信息保存(GSIP)。具体而言,对于低频信息保存,将重放节点输入到旧模型中获得的旧节点表示与新模型中该节点及其邻居的输出对齐,然后池化后全局匹配新旧输出。为了保持高频信息,鼓励新节点表示模仿旧节点表示的近邻对相似性。与之前的方法相比,GSIP在遗忘度量方面提高了10%,我们的框架还可以无缝地集成现有的重放设计。

论文链接:https://openreview.net/pdf?id=tJGX7tpGO8

论文代码:https://github.com/Jillian555/GSIP

论文题目:Persistence Homology Distillation for Semi-supervised Continual Learning

作者:范妍(博士研究生), 王煜,朱鹏飞,陈东月,胡清华

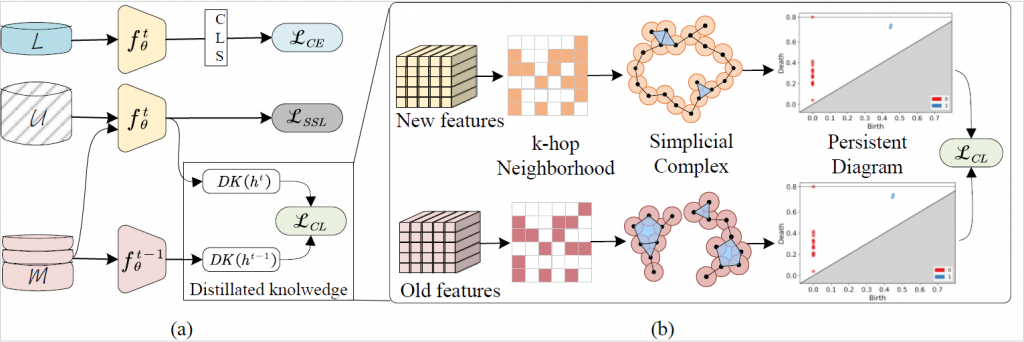

论文概述:半监督持续学习(SSCL)在解决半监督数据的灾难性遗忘问题方面受到了显著关注。知识蒸馏利用数据表示和关联相似性在SSCL中显示出保留知识的显著潜力。然而,传统的蒸馏策略在处理带有不准确或噪声信息的未标记数据时常常失败,这限制了它们在持续学习过程中特征空间发生显著变化时的效率。为了解决这一问题,我们提出了持续同调蒸馏(PsHD)以在半监督持续学习中保留对噪声不敏感的内在结构信息。首先,我们通过构建视觉数据在不同尺度上的单纯形的演化来表示持续同调特征,其中多尺度特征保证了在噪声干扰下的稳定性。接下来,我们提出了一种持续同调蒸馏损失,并设计了一种高效的加速算法,以减少模型训练过程中持续同调的计算成本。此外,我们理论上证明并实验验证了PsHD相比于样本表示和关联相似性蒸馏方法的稳定性。最后,在三个广泛使用的数据库上验证了提出的PsHD在所有基线中表现最佳,提高了3.2%的性能同时减少50%的记忆缓冲区大小,表明了该方法在SSCL中对未标记数据的利用潜力。

论文链接:https://openreview.net/pdf?id=qInb7EUmxz

论文代码:https://github.com/fanyan0411/PsHD

ECCV(European Conference on Computer Vision),即欧洲计算机视觉国际会议,是计算机视觉领域的第三大顶级会议。它通常每两年举办一次,举办地点则会在欧洲的不同城市轮换。自1990年第一届会议在意大利举办以来,ECCV已经成为了欧洲计算机视觉领域最重要的学术会议之一。它不仅为欧洲的研究者和企业提供了一个交流和展示研究成果的平台,还推动了计算机视觉技术在欧洲的应用和发展。

论文题目:Visible and Clear: Finding Tiny Objects in Difference Map

作者:曹兵,姚海屿(硕士研究生),朱鹏飞,胡清华

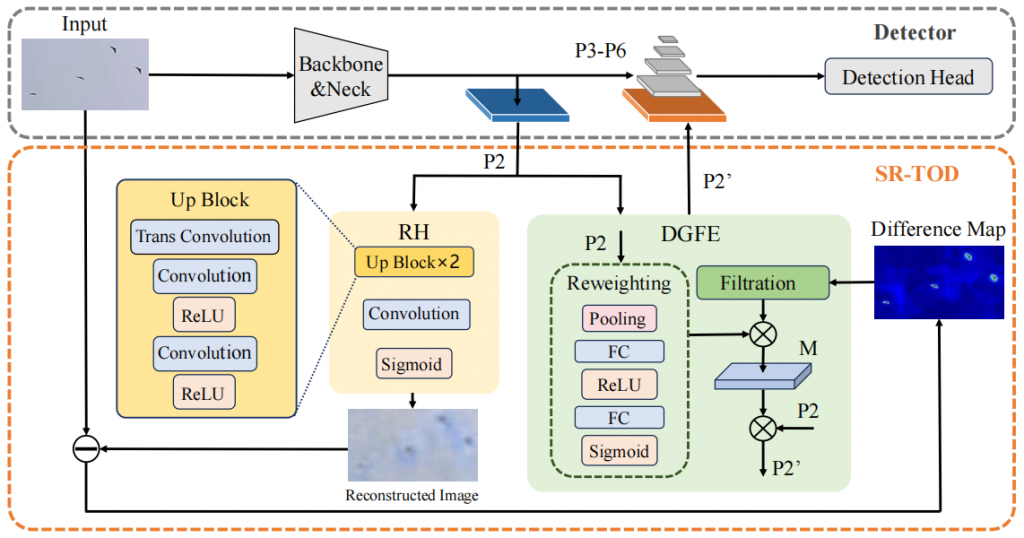

论文概述:微小目标检测(TOD)是目标检测领域的关键挑战之一。大多数通用检测器在检测微小目标时性能会出现显著下降。该任务的主要挑战在于提取微小目标的有效特征。微小目标在主干网络中信息丢失严重,这导致了其微弱的信号和扭曲的表示。现有方法通常使用基于生成的特征增强,但这种方式往往会受到虚假纹理和伪影的严重影响,使得微小目标特定的特征难以在检测中清晰可见。为解决这一问题,我们提出了自重建微小目标检测(SR-TOD)框架。我们首次在检测模型中引入自重建机制,并发现其与微小目标之间存在强相关性。具体而言,我们在检测器颈部后嵌入一个重建头(RH),构造重建图像与输入图像之间的差异图,其对微小目标高度敏感。这启发我们在差异图的引导下增强微小目标的弱表示,从而提高微小目标对于检测器的可见性。因此,我们进一步开发了差异图引导的特征增强(DGFE)模块,将丢失的微小目标信息变成一种有效的先验指导,使得微小目标的特征表示更清晰。此外,我们进一步提出了一个新的多实例反无人机数据集DroneSwarms,包含大量目前平均尺度最小(约7.9像素)的微小目标。在DroneSwarms和VisDrone2019等数据集上的广泛实验证明了所提方法的有效性。

论文链接:https://arxiv.org/abs/2405.11276

论文代码:https://github.com/Hiyuur/SR-TOD

ICML是机器学习与人工智能领域的国际顶级学术会议,是机器学习领域历史最悠久的、规模最大、影响最广的顶级学术会议之一,也是中国计算机学会CCF推荐的A类会议。

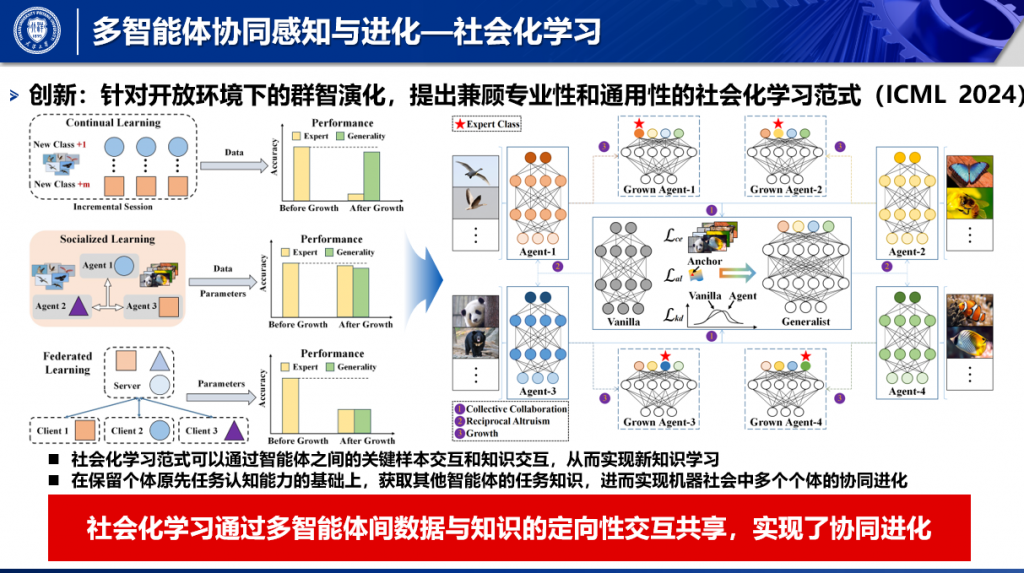

论文题目:Socialized Learning: Making Each Other Better Through Multi-Agent Collaboration

作者:姚鑫杰(博士研究生),王煜,朱鹏飞,林婉瑜,李佳璐,李维浩,胡清华

论文概述:近期,团队提出了一个多智能体协同感知的社会化学习框架,已被2024国际机器学习大会(ICML)录用。在开放环境下,智能体往往需要连续学习新知识。当前连续/增量学习方法往往仅关注单一智能体如何从充分的数据中学习,但人类的连续学习过程往往通过与掌握相关知识的其他个体进行交流,学习有限样本即可实现。针对此问题,团队提出了一类社会化学习范式,不同智能体通过分享从数据中学习到的知识,实现新知识学习。同时,不同于联邦学习,社会化学习范式可以通过智能体之间的关键样本交互和知识交互,在保留个体原先任务认知能力的基础上,获取其他智能体的任务知识,进而实现机器社会中多个个体的协同进化。

论文链接:https://openreview.net/pdf?id=aaeJpJw5Ur

论文代码:https://github.com/yxjdarren/IHGAT

IJCAI(International Joint Conference on Artificial Intelligence),即国际人工智能联合会议,是人工智能领域中最重要的学术会议之一,每年吸引全球学术界和企业界逾千人参加。 中国计算机学会(CCF)推荐国际学术会议目录将IJCAI列为人工智能领域A类会议

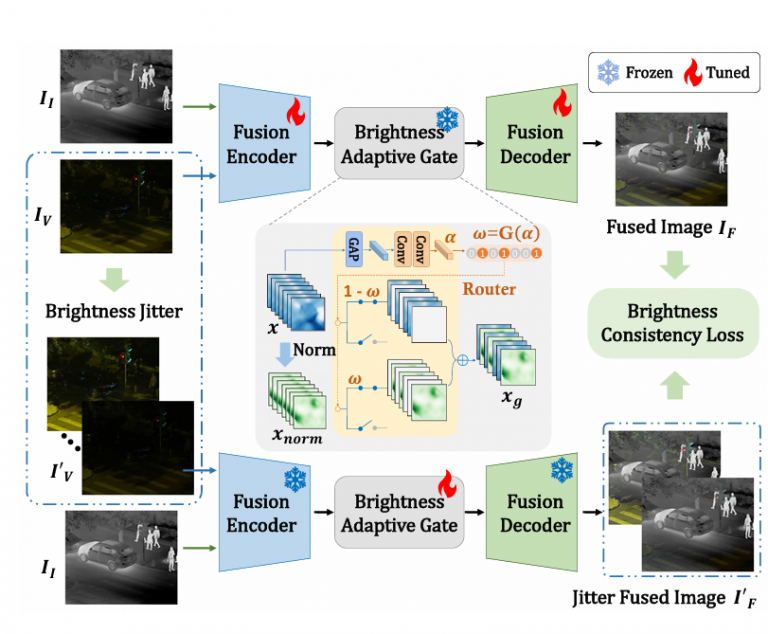

论文题目:Dynamic Brightness Adaptation for Robust Multi-modal Image Fusion

作者:孙一铭(博士研究生),曹兵,朱鹏飞,胡清华

论文概述:红外和可见光图像融合旨在结合不同模态的优势特征生成信息丰富的新图像。在现实场景中,可见光模态容易受到环境亮度动态波动的影响,从而呈现过亮或过暗导致图像纹理退化。现有的融合方法难以在动态亮度扰动下实现鲁棒融合,导致融合结果不可避免地受到亮度波动的影响,这极大地降低了融合图像的视觉保真度。因此,在实际应用中红外和可见光图像融合模型应具备鲁棒的自适应能力,以应对环境亮度的变化。本文提出了一种亮度自适应图像动态融合框架,称为BA-Fusion,以适应亮度变化并在动态环境亮度下实现鲁棒的多模态图像融合。具体来说,本文提出了亮度自适应门控(Brightness Adaptive Gate, BAG)模块,用于学习对亮度信息的感知,进而动态选择出亮度相关通道进行归一化以消除亮度干扰,同时保留亮度无关通道中的结构特征信息。为了训练BAG模块,本文设计了一个亮度一致性损失函数,约束动态亮度扰动下融合图像的亮度保持一致。通过交替训练策略,BAG模块逐渐建立了亮度变化与特征通道之间的联系,使得提出的BA-Fusion具有亮度自适应的鲁棒多模态图像融合能力。大量的实验表明,本文方法在保留多模态图像丰富的信息和视觉保真度方面优于最先进的对比方法,并且所提出的模型在不同亮度水平下也表现出最鲁棒的性能。

International Journal of Computer Vision(IJCV)详细介绍了这一快速增长领域的科学和工程。常规文章介绍具有广泛普遍意义的主要技术进展。调查文章提供了对技术现状的批评性评论和/或相关主题的教程性介绍。 覆盖范围包括 - 计算机视觉的数学、物理和计算方面:图像形成、处理、分析和解释;机器学习技术;统计方法;传感器。 - 应用:基于图像的渲染、计算机图形学、机器人学、照片解释、图像检索、视频分析和注释、多媒体等等。 - 与人类感知的联系:人类视觉的计算和建筑方面。 该杂志还包括书评、立场文件、主要科学人物的社论,以及其他在线材料,如静态图像、视频序列、数据集和软件。 详细介绍快速发展的计算机视觉领域的科学和工程。 介绍具有广泛普遍意义的主要技术进展 为新的研究成果提供快速出版途径 提供对技术现状的批判性评论和/或相关主题的教程性介绍 92%的作者在回答调查时表示,他们一定会或可能会再次在该杂志上发表文章。

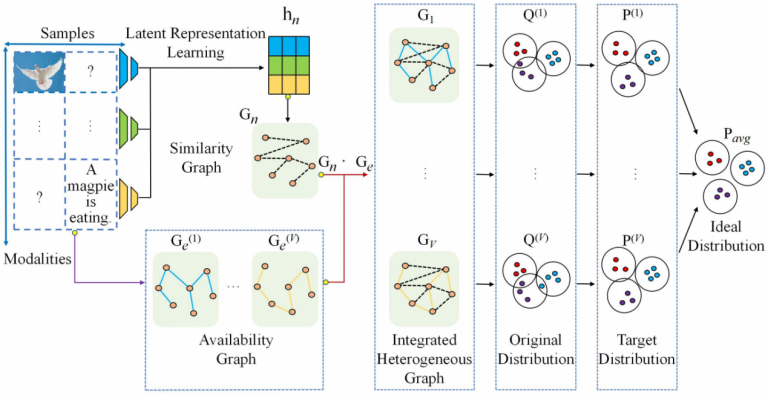

论文题目:Integrated Heterogeneous Graph Attention Network for Incomplete Multi-Modal Clustering

作者:王煜,姚鑫杰(博士研究生),朱鹏飞,李维浩,胡清华

论文概述:针对开放环境下智能无人系统多模态数据缺失导致难以有效学习的问题,本文提出了一种创新的基于集成异质图注意力网络的多模态协同进化方法。具体地,本文首先通过构建相似性图和模态特定可用性图,生成一组集成异质图,以最大化利用不同缺失样本和模态之间的互补性,从而突破模型在缺失数据下难以学习的瓶颈。随后,模型采用注意力机制对邻居节点进行聚合,进一步深化了对不同样本和模态之间互补信息的学习,增强了模型的表达能力。最后,通过引入概率分布一致性嵌入,确保了模型输出的一致性,在多模态协同学习中实现更优的性能。成果录用于2024年国际顶级学术期刊《International Journal of Computer Vision》。

论文链接:https://link.springer.com/article/10.1007/s11263-024-02066-y

论文代码:https://github.com/yxjdarren/IHGAT

CVPR(IEEE Conference on Computer Vision and Pattern Recognition),即国际计算机视觉与模式识别会议,是计算机视觉领域最具影响力的会议之一。它通常每年6月份在美国的不同城市举办。自1983年第一届会议在美国华盛顿举办以来,CVPR已经成为了计算机视觉领域最重要的学术会议之一。在过去的几十年里,CVPR见证了计算机视觉技术的快速发展,吸引了越来越多的研究者和企业参与。

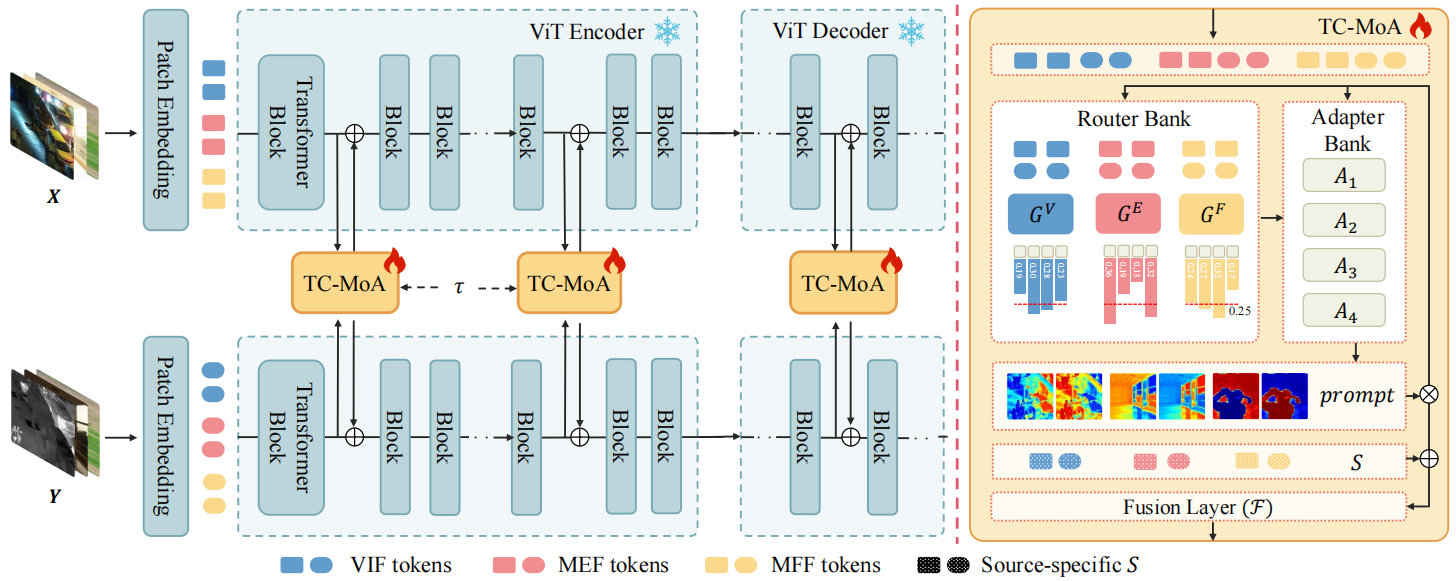

论文题目:Task-Customized Mixture of Adapters for General Image Fusion

作者:朱鹏飞,孙洋(硕士研究生),曹兵,胡清华

论文概述:通用图像融合旨在整合来自多源图像的重要信息。然而,由于不同融合任务之间存在巨大差距,各自的融合机制在实践中差异很大,导致各子任务之间的性能有限。为了解决这个问题,我们为通用图像融合提出了一种新的任务定制混合Adapters(TC-MoA),在一个统一的模型中自适应地提示各种融合任务。我们借鉴了混合专家(MoE)的设计,高效微调混合Adapters,以提示预先训练好的基础模型。特定任务路由网络会定制这些Adapters的混合,以便从具有动态地从不同源图像中提取特定任务信息,执行自适应视觉特征提示融合。这些Adapters可在不同任务间共享,并受到互信息正则化的约束,从而确保与不同任务的兼容性,同时实现多源图像的互补。值得注意的是,我们的 TC-MoA 可以控制不同融合任务的主导强度偏差,成功地将多个融合任务统一在一个模型中。广泛的实验表明,TC-MoA 在学习共性方面优于其他竞争方法,同时还保留了一般图像融合(多模态、多曝光和多焦点)的兼容性,并在更广泛的实验中表现出惊人的可控性。

论文链接:https://arxiv.org/abs/2403.12494

论文代码:https://github.com/YangSun22/TC-MoA

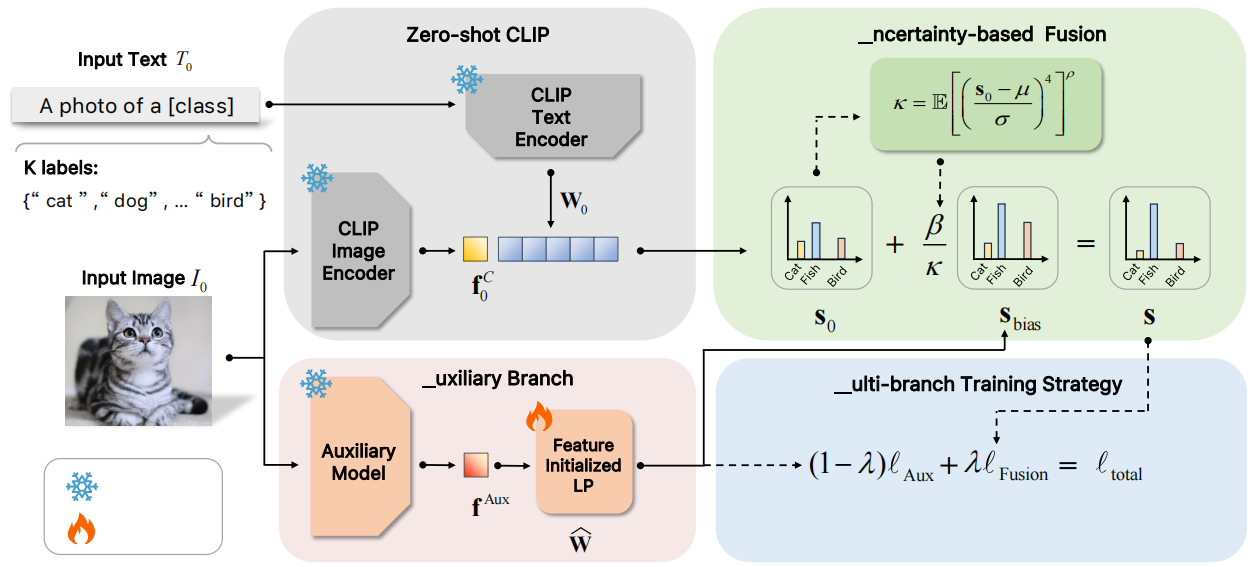

论文题目:AMU-Tuning: Learning Effective Bias for CLIP-based Few-shot Classification

作者:汤钰炜(硕士研究生),林桢熠(硕士研究生),王旗龙,朱鹏飞,胡清华

论文概述:最近,预训练的视觉-语言模型(如CLIP)在few-shot learning领域显示出了巨大的潜力,吸引了大量的研究关注。虽然人们已经为提高CLIP的few-shot泛化能力做了大量努力,但现有方法有效的关键因素尚未得到充分研究,限制了CLIP在few-shot learning领域的进一步探索。在这篇文章中,我们首次从logit bias的角度,引入了一个统一的公式分析现有的基于CLIP的few-shot learning方法,这促进我们学习一个有效的logit bias来进一步提高基于CLIP的few-shot learning方法的性能。

为此,我们分解了三个涉及logit bias计算的关键组件(即logit特征、logit预测器和logit融合),并在经验上分析了对few-shot分类性能的影响。根据对关键组件的分析,这篇文章提出了一种新的AMU-Tuning方法,学习有效的logit bias来实现基于CLIP的few-shot分类方法。具体来说,我们的AMU-Tuning方法通过利用适当的辅助特征来预测logit偏差,这些特征被输入一个高效的特征初始化线性分类器,该分类器使用多分支训练。最后,开发了一种基于不确定性的融合方法,将logit bias引入到CLIP中,用于few-shot分类。实验是在几个广泛使用的基准上进行的,结果表明我们提出的AMU-Tuning明显优于同类方法的性能,同时在没有额外技巧的条件下实现了最先进的性能。

论文链接:https://openaccess.thecvf.com/content/CVPR2024/papers/Tang_AMU-Tuning_Effective_Logit_Bias_for_CLIP-based_Few-shot_Learning_CVPR_2024_paper.pdf

论文代码:https://github.com/TJU-sjyj/AMU-Tuning

IEEE Trans Cybernetics是一个被SCI、EI等多个数据库收录的学术期刊,它在控制系统、人工智能、模式识别、机器学习等领域的研究成果方面具有很高的学术影响力。该期刊发表的论文涵盖了这些领域的前沿研究成果和创新技术,对于学术研究人员来说具有很高的参考价值。

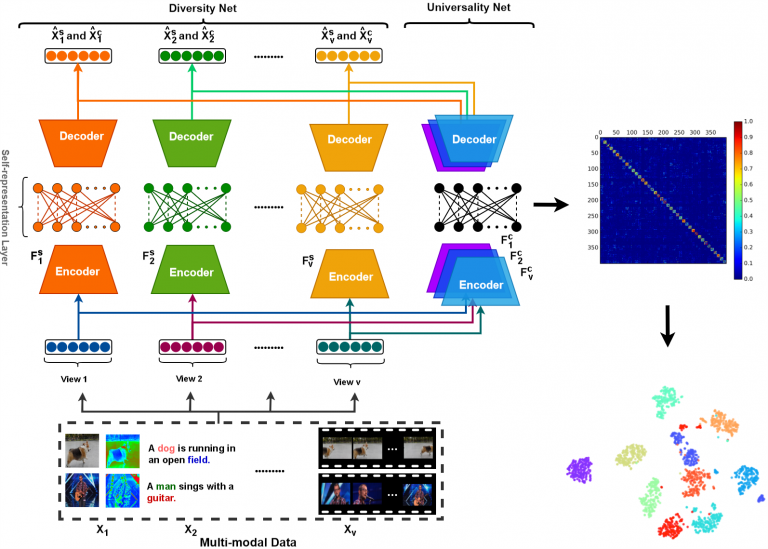

论文题目:Multi-View Deep Subspace Clustering Networks

作者:朱鹏飞,姚鑫杰(博士研究生),王煜,惠彬原,杜大为,胡清华

论文概述:针对现有多视图子空间聚类方法中多视图关系未嵌入特征学习及端到端学习方式不适用于多视图聚类的问题,本文提出了一种创新的多视图深度子空间聚类网络。具体而言,多视图深度子空间聚类网络通过端到端的方式学习多视图自表示矩阵,旨在融合多种互补信息,发现数据的内在结构。多视图深度子空间聚类网络由两个子网络组成,即多样性网络和通用性网络。在网络架构上,首先通过深度卷积自编码器构建一个隐空间,并在该隐空间中利用全连接层学习自表示矩阵。多样性网络专注于学习特定于每个视图的自表示矩阵,而通用性网络则学习所有视图通用的自表示矩阵。为了充分挖掘多视图之间的互补性,本文引入了Hilbert-Schmidt独立性准则作为多样性正则化器,以捕获视图之间非线性和高阶的关系。此外,由于不同视图共享相同的标签空间,每个视图的自表示矩阵通过通用性正则化与通用矩阵对齐,从而确保了跨视图的一致性。成果录用于2024年国际顶级学术期刊《IEEE Transactions on Cybernetics》。

论文链接:https://ieeexplore.ieee.org/abstract/document/10478097

论文代码:https://github.com/yxjdarren/MvDSCN

AAAI, 全称AAAI Conference on Artificial Intelligence, 该会议是国际人工智能领域顶级会议之一,本届会议录用率为23.75%。

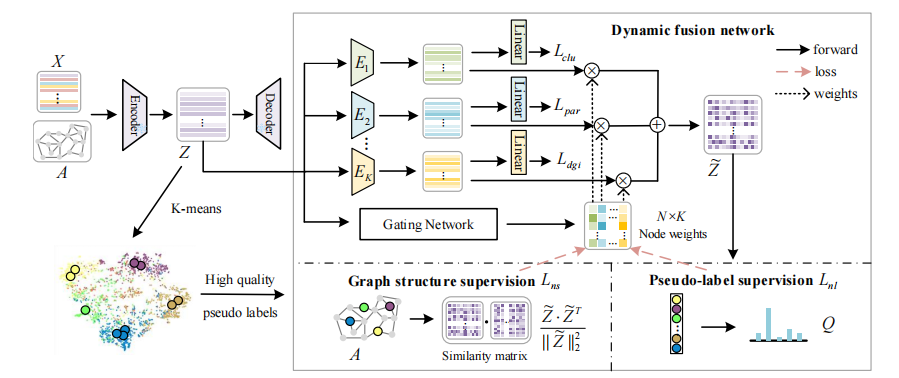

论文题目:Every Node is Different: Dynamically Fusing Self-Supervised Tasks for Attributed Graph Clustering

作者:朱鹏飞,王倩(硕士研究生),王煜,李佳璐,胡清华

论文概述:属性图聚类是一种无监督的任务,它将节点划分为不同的簇。自监督学习在处理这一任务方面显示出了巨大的潜力,最近的一些研究同时学习多个自监督任务,进一步提高了性能。目前,不同的自监督任务为所有节点分配相同的权重集合。然而,论文中观察到一些相邻处于不同簇的节点对不同的自监督任务需要显著不同的权重。为了解决这个问题,该论文设计了一种新颖的图聚类方法,即动态融合自监督学习。该方法使用来自门控网络的不同权重来融合从不同的自监督任务中提取的特征,并且提出了一种包含伪标签和图结构的双层自监督策略以有效地学习门控网络。充分的实验结果也证明了论文所提出方法的有效性。

论文链接:https://ojs.aaai.org/index.php/AAAI/article/view/29664

论文代码:https://github.com/q086/DyFSS

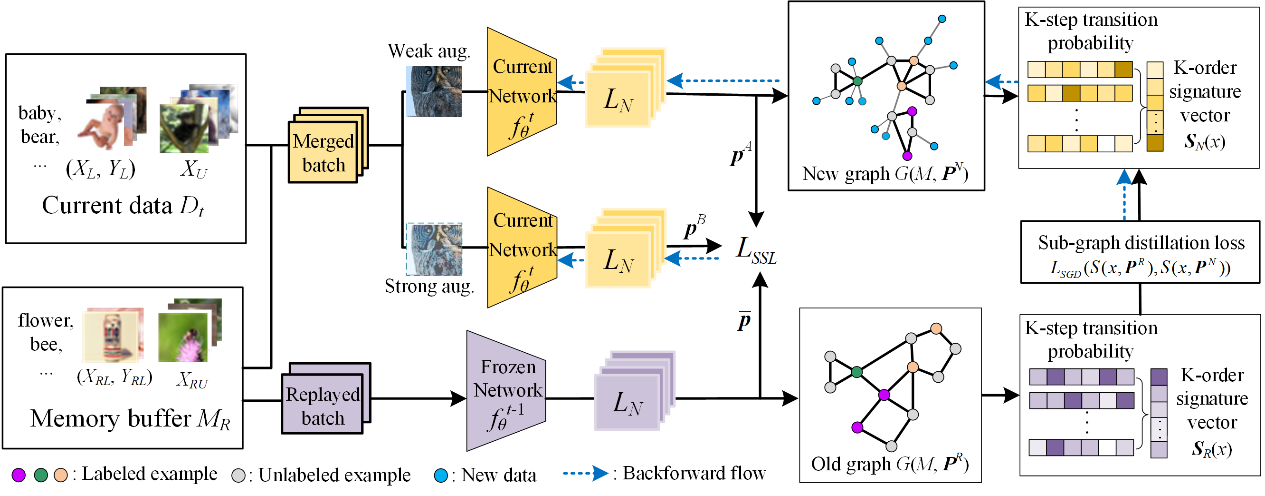

论文题目: Dynamic Sub-graph Distillation for Robust Semi-supervised Continual Learning

作者:范妍(博士研究生),王煜,朱鹏飞,胡清华

论文概述: 连续学习策略通常需要大量的标记样本,限制了其在实际场景中的应用。在该论文中,我们提出利用数据的结构稳定性实现半监督连续学习(SSCL),即模型持续地学习新的标记受限的数据。我们分析并证明了未标记数据的不可靠分布会导致连续学习的不稳定, 并且无标记数据的遗忘问题没有得到解决, 该问题严重影响了SSCL的学习性能。为解决这一问题,我们提出了一种动态子图蒸馏(Dynamic Sub-graph Distillation, DSGD)的半监督持续学习方法,通过利用语义和结构信息在无标记数据上实现更稳定的知识蒸馏。首先,我们形式化定义了通用结构蒸馏模型,并为持续学习过程设计了动态图的构造方法。接下来,我们提出结构化的蒸馏向量,并设计了一种动态的子图蒸馏算法,从而实现了端到端的训练,能够适应不同尺度的任务扩展。最后,我们在三个数据集 CIFAR10、CIFAR100 和 ImageNet-100 上以不同的监督比例进行了实验。实验结果证明了我们的方法对无标记数据分布偏差的鲁棒性,并且在目前最新技术的基础上实现了性能的显著提升。

论文链接:https://ojs.aaai.org/index.php/AAAI/article/view/29079

论文代码:https://github.com/fanyan0411/DSGD

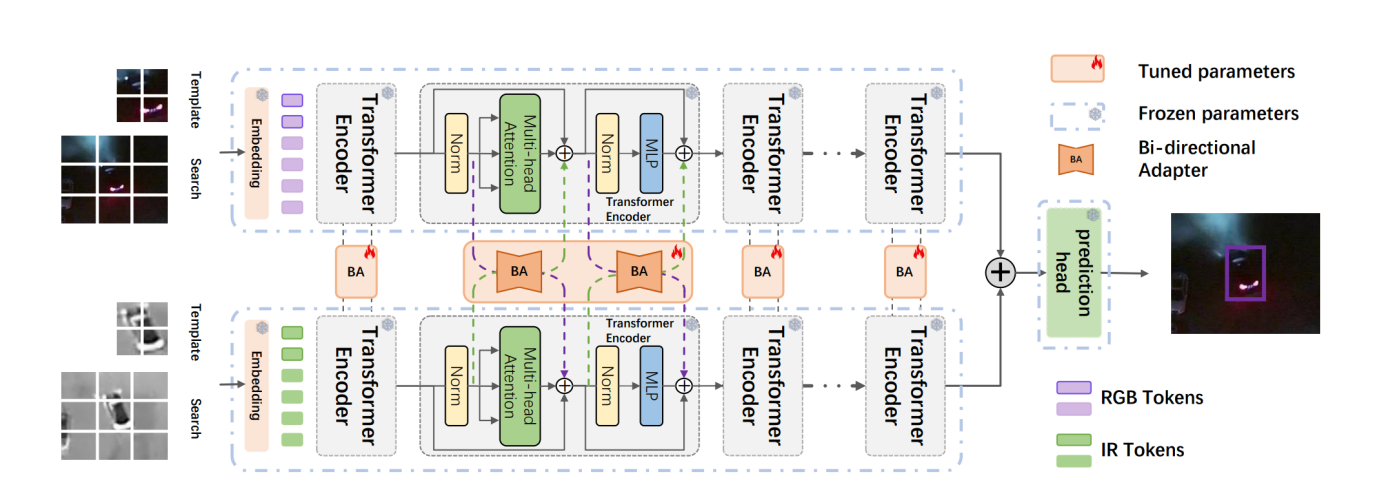

论文题目:Bi-directional Adapter for Multimodal Tracking

作者:曹兵,郭俊良(硕士研究生),朱鹏飞,胡清华

论文概述:由于计算机视觉的快速发展,单模态(RGB)目标跟踪近年来取得了重大进展。考虑到单一成像传感器的局限性,引入多模态图像(RGB、红外等)来弥补这一缺陷,以实现复杂环境下全天候目标跟踪。然而,当主导模态在开放场景下动态变化时难以获取充分的多模态跟踪数据,现有技术大多无法动态提取多模态互补信息,导致跟踪性能不理想。为了解决这一问题,我们提出了一种基于通用双向adapter的多模态视觉提示跟踪模型,实现多模态相互交叉提示。我们的模型由一个通用的双向adapter和共享参数的特定于模态的transformer编码器分支组成。编码器使用冻结的预训练的基础模型权重分别提取每个模态的特征。我们开发了一种简单而有效的轻量级adapter,将特定于模态的信息从一种模态转移到另一种模态,以自适应的方式执行视觉特征提示融合。通过添加更少(0.32M)的可训练参数,我们的模型与全微调方法和基于提示学习的方法相比获得了更好的跟踪性能。

论文链接:https://ojs.aaai.org/index.php/AAAI/article/view/27852

论文代码:https://github.com/SparkTempest/BAT

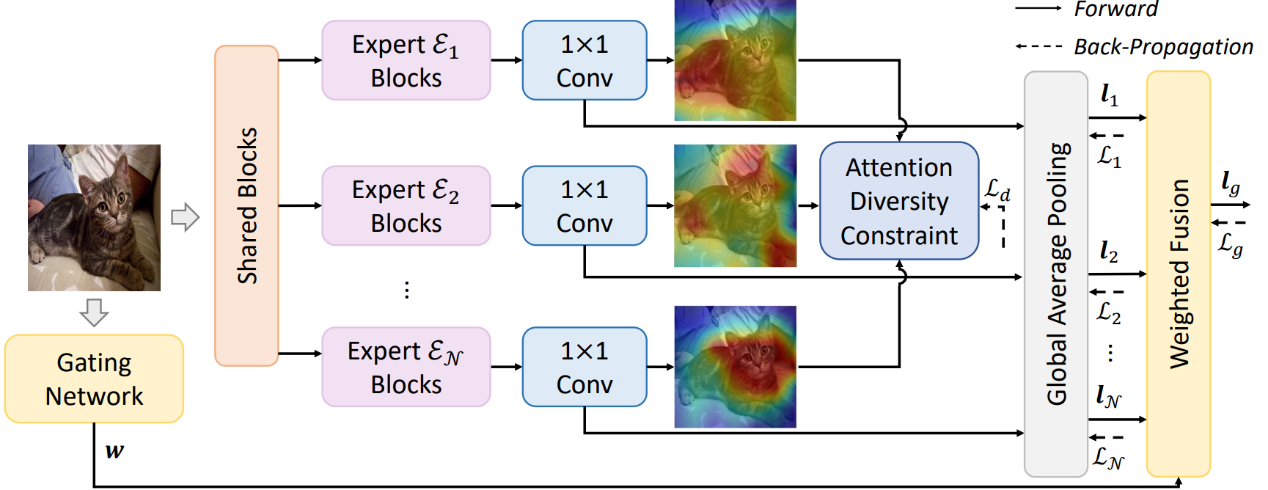

论文题目:Exploring Diverse Representations for Open Set Recognition

作者:王煜,穆郡贤(硕士研究生),朱鹏飞,胡清华

论文概述:开放集识别任务要求模型对属于已知类的样本进行分类,同时在测试过程中拒绝未知样本。目前,生成模型在该任务中的表现通常优于判别模型,但最近的研究表明,生成模型在复杂任务上计算上不可行或性能不稳定。在本文中,作者深入分析了该任务,并发现学习补充表示在理论上可以降低开放空间风险。在此基础上,提出了多专家多样化注意力融合模型。该判别式模型由多个学习不同表示的专家组成,这些专家通过注意多样性正则化模块来学习,以确保注意图是相互不同的。每个专家的预测进行自适应融合,并通过打分函数拒绝未知样本。标准和大规模开放集识别任务上的大量实验结果表明,该方法在AUROC上的性能优于现有的生成模型高达9.5%,且计算成本较低。该方法还可以无缝地融合到现有的分类模型中。

论文链接:https://ojs.aaai.org/index.php/AAAI/article/view/28385

论文代码:https://github.com/Vanixxz/MEDAF

IEEE TNNLS创办于1990年,属机器学习、信息科学、人工智能的交叉学科领域,是神经网络和学习系统方面的国际顶级杂志,也是中科院分区1区Top期刊。

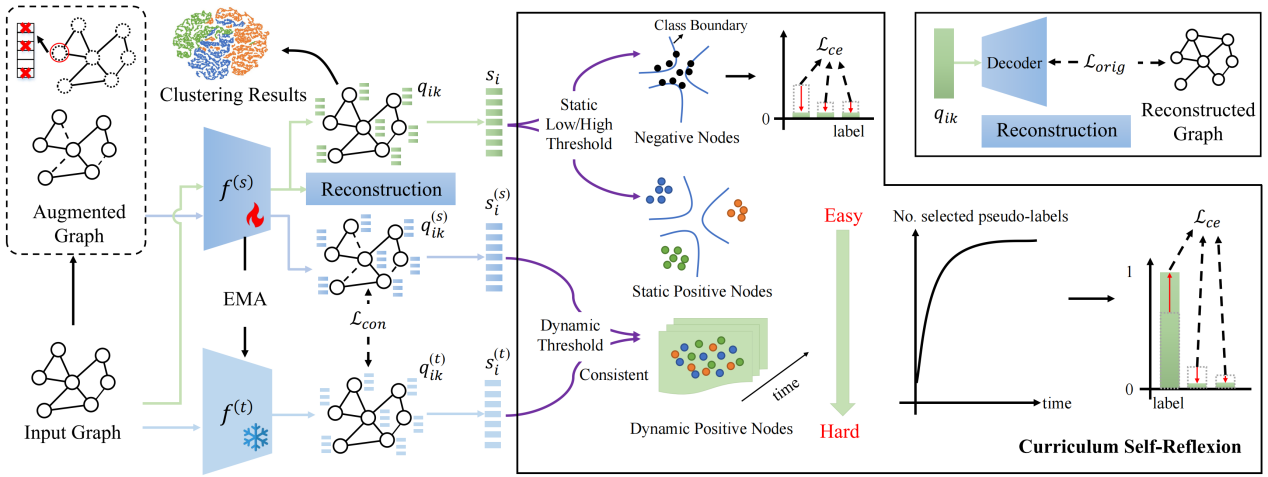

论文题目:Boosting Pseudo Labeling with Curriculum Self-Reflexion for Attributed Graph Clustering

作者:朱鹏飞,李佳璐(博士研究生),王煜,肖斌,张敬林,林婉瑜,胡清华

论文概述:属性图聚类是一种无监督学习任务,旨在将图的各个节点划分为不同的组。现有方法侧重于设计各种借口任务来获得合适的监督信息进行表征学习,其中预测式方法显示出很大的潜力。然而,这些方法(1)会产生对聚类目标的辅助任务偏差;(2)由于静态阈值的设置而引入标签噪声。为了解决这个问题,我们提出了一种新的自监督学习方法,即基于课程自我反思的伪标签设计方法(PLCSR),该方法通过挖掘模型自身信息来学习可靠的伪标签,以自我反思的方式实现节点的渐进式处理。首先,利用原始编码器参数的指数移动平均构造自辅助编码器来代替辅助任务,这为寻找高置信度伪标签提供了额外的视角。其次,设计了一种基于动态阈值的课程选择策略,以更准确地充分利用图节点。除了在初始阶段选择的高置信度简单节点外,还为两个编码器产生一致预测的困难节点分配伪标签,以避免欠学习问题。对于其他高不确定的困难节点,模型不做判断以尽量减少对优化的不利影响。大量实验表明,PLCSR显著优于最先进的预测式方法CDRS,在聚类准确率方面提高了6%以上。

论文链接:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10669618

论文代码:https://github.com/Jillian555/PLCSR

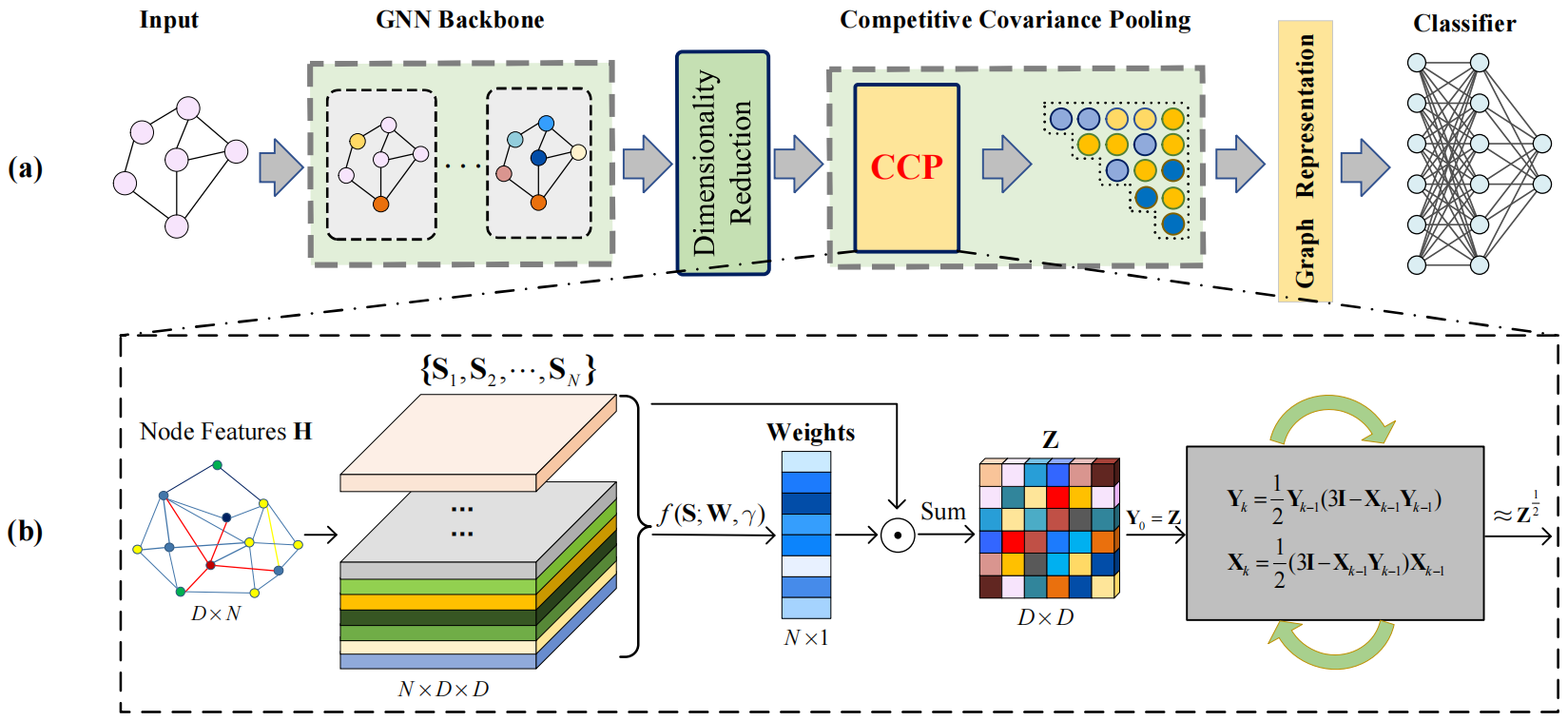

论文题目:CCP-GNN: Competitive Covariance Pooling for Improving Graph Neural Networks

作者:朱鹏飞,李佳璐(博士研究生),董喆,胡清华,王啸,王旗龙

论文概述:图神经网络(GNNs)在图分类任务上取得了一定进展,其中通过汇总节点特征来生成图表示的全局池化对最终性能起着关键作用。现有的GNNs大多采用全局平均池化或其变体构建,没有充分考虑节点特异性,忽略了节点特征固有的丰富统计特性,限制了GNNs的分类性能。因此,本文提出了一种基于图结构的竞争协方差池化(CCP)算法,即图通常由节点集的关键部分识别。首先,CCP生成节点的二阶表示以探索节点特征中固有的丰富统计信息,将其输入基于竞争的注意力模块,通过学习节点权重有效发现关键节点。随后,CCP通过求和将节点级二阶表示与节点权重结合起来,为每个图产生协方差表示,同时引入迭代矩阵归一化来考虑协方差的几何形状。CCP可以与各种GNNs(即CCP-GNN)灵活集成,以很少的计算成本提高了图分类任务的性能,在7个图级基准数据集上的实验结果表明,CCP-GNN的性能优于或可与现有技术相媲美。

论文链接:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10509794

论文代码:https://github.com/Jillian555/CCP-GNN

此外,我组成员参与发表的论文如下:

Peiliang Huang, Dingwen Zhang, De Cheng, Longfei Han, Pengfei Zhu, Junwei Han. M-RRFS: A Memory-Based Robust Region Feature Synthesizer for Zero-Shot Object Detection. Internatinal Journal of Computer Vision2024

Chenchen Jiang, Huazhong Ren, Hong Yang, Hongtao Huo, Pengfei Zhu, Zhaoyuan Yao, Jing Li, Min Sun, Shihao Yang. M2FNet: Multi-modal fusion network for object detection from visible and thermal infrared images. International Journal of Applied Earth Observation and Geoinformation2024

2024年10月,VisDrone团队在昇腾AI创新大赛天津赛区决赛中凭借自主设计的“鹰眼:无人机极小目标检测算法”脱颖而出,荣获金奖。

2024年12月,国家自然科学基金重点项目“无人集群感知的自主社会化学习与进化”项目实施方案顺利汇报。

1、2024年2月团队博士研究生范妍、硕士研究生郭俊良参加AAAI 2024

2、2024年7月,团队博士研究生姚鑫杰参加ICML 2024

3、2024年7月,团队在CCDM会议举办Visdrone无人机视觉挑战赛

4、2024年8月,团队博士研究生孙一铭参加IJCAI 2024

5、2024年9月,团队硕士研究生姚海屿参加ECCV 2024

6、2024年11月,团队协助举办的CCF进高校活动在天津大学北洋园成功举行

7、团队学生参加第二届中国多智能体系统会议

8、团队学生参加VALSE 2024 视觉与学习青年学者研讨会

1、硕士研究生孙洋获评2024年度研究生国家奖学金

2、博士研究生姚鑫杰获评2024年度研究生国家奖学金

3、博士研究生姚鑫杰获评天津大学智能与计算学部第四届杰出青年

@article{cao2024visible,

title={Visible and Clear: Finding Tiny Objects in Difference Map},

author={Cao, Bing and Yao, Haiyu and Zhu, Pengfei and Hu, Qinghua},

journal={arXiv preprint arXiv:2405.11276},

year={2024}

}

<pre>

@ARTICLE{Gao22LUSS,

author={Gao, Shanghua and Li, Zhong-Yu and Yang, Ming-Hsuan and Cheng, Ming-Ming and Han, Junwei and Torr, Philip},

title={Large-scale Unsupervised Semantic Segmentation},

journal={IEEE Transactions on Pattern Analysis and Machine Intelligence},

year={2023},

volume={45},

number={6},

pages={7457-7476},

doi={10.1109/TPAMI.2022.3218275}

}

</pre>